https://github.com/ahmetfurkandemir/deep-learning-6-optimization

Deep Learning(6) - Gradient Descent With Momentum , RMSprop, Adam optimization

https://github.com/ahmetfurkandemir/deep-learning-6-optimization

Last synced: 6 months ago

JSON representation

Deep Learning(6) - Gradient Descent With Momentum , RMSprop, Adam optimization

- Host: GitHub

- URL: https://github.com/ahmetfurkandemir/deep-learning-6-optimization

- Owner: AhmetFurkanDEMIR

- Created: 2020-08-09T07:20:41.000Z (about 5 years ago)

- Default Branch: master

- Last Pushed: 2020-08-09T07:38:02.000Z (about 5 years ago)

- Last Synced: 2025-04-15T21:52:18.502Z (6 months ago)

- Language: Jupyter Notebook

- Size: 2.9 MB

- Stars: 15

- Watchers: 2

- Forks: 0

- Open Issues: 0

-

Metadata Files:

- Readme: README.md

Awesome Lists containing this project

README

# Optimization

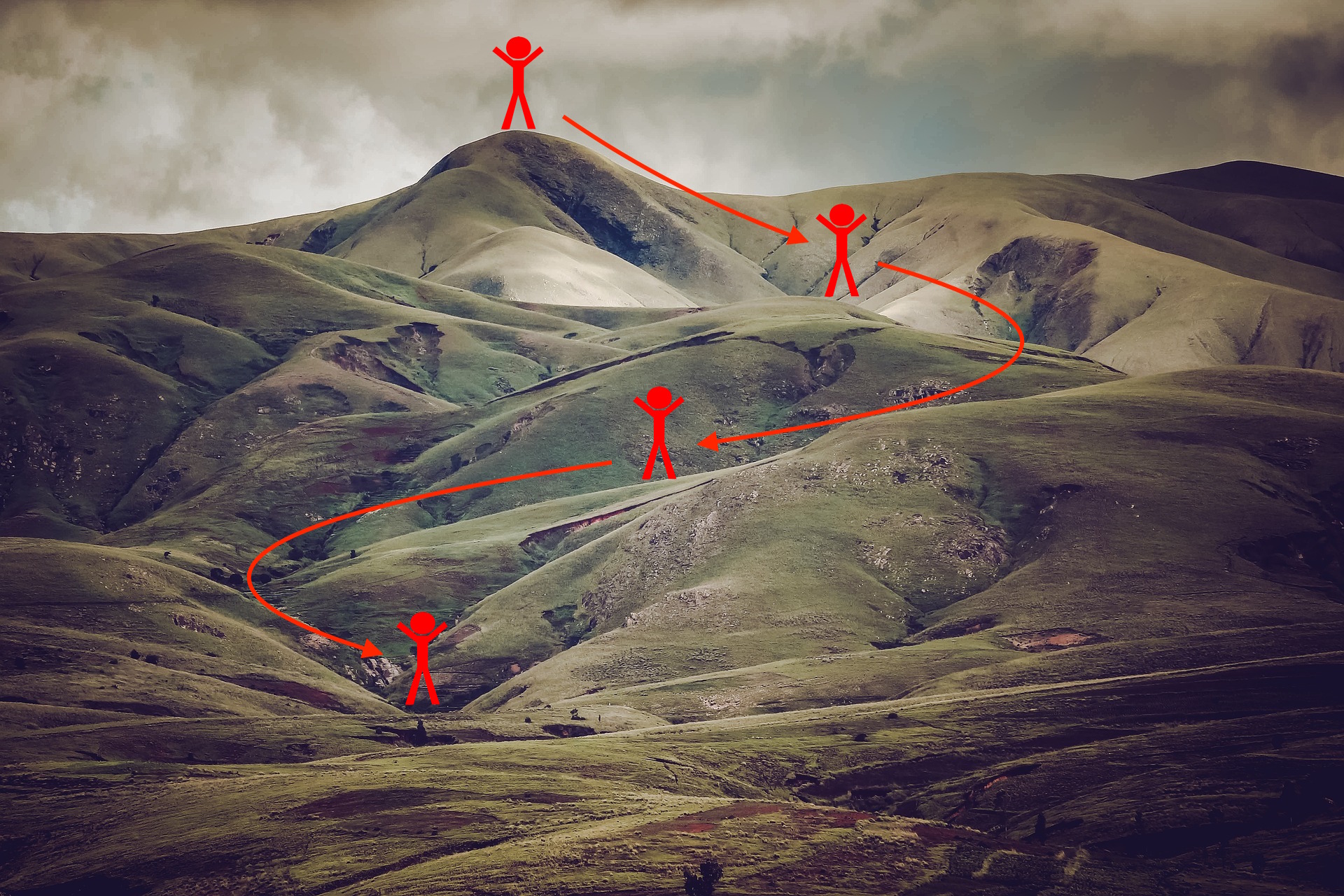

* Sizi minimum maliyete götürmek için kullanabileceğiniz birçok farklı optimizasyon algoritması vardır. Benzer şekilde, bu tepeden en alçak noktaya birçok farklı patika vardır.

# Adımlar

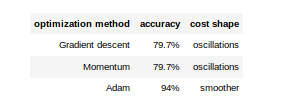

* Gradient Descent (Dereceli alçalma)

* Mini-Batch Gradient descent (Mini Toplu Gradyan inişi)

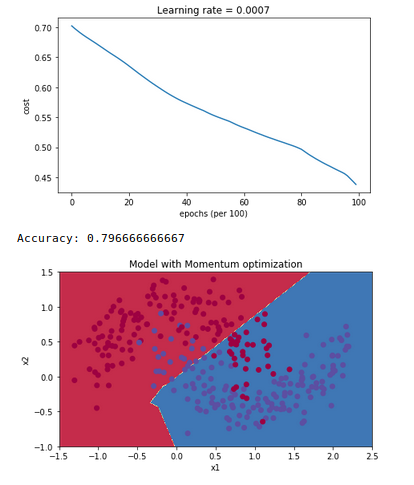

* Momentum

* Adam Optimization

# Çıkarımlar

* Adam ve RMS prop arasındaki sezgiyi anlamak

* Mini toplu gradyan inişinin önemini öğrenmek

* Momentumun modelinizin genel performansı üzerindeki etkilerini görmek

* Kaynak : Improving Deep Neural Networks: Hyperparameter tuning, Regularization and Optimization (Coursera) - https://www.coursera.org/learn/deep-neural-network